Ghost 博客数据自动备份和图片自动压缩

阅读本文需要具备的前提:

- 可自行在云主机上部署 Ghost

- 熟悉 Git 和 GitHub 使用

我已经使用 Ghost 博客 接近 2 年了。目前来讲,随着 1.0 的正式发布,版本迭代非常快,体验也越来越好。

这篇文章中,我将分享两个使用过程中的小技巧,分别是:数据自动备份和图片自动压缩。

数据自动备份

Ghost 博客默认不提供自动备份和图片压缩功能,所以需要借助第三方工具实现。由于平常和 Git 打交道的时间比较多,再加上每天都会使用 GitHub。所以,我就想借助于 GitHub 来对 Ghost 数据进行备份。

如果你把 Ghost 托管在 Ubuntu 系统的云主机(推荐 AWS Lightsail)上,默认的安装目录一般是 /var/www/ghost/。那么,该文件夹下方就存放了 Ghost 一系列安装文件。其中,./ghost/content 路径下方存放了博客的数据文件。结构如下:

.

├── apps

├── data

├── images

├── settings

└── themes

由于我使用 SQLite 数据库,所以数据库文件就直接在 ./ghost/content/data 下方,备份起来就更加方便了。

接下来,你可以在 GitHub 中新建一个私有仓库(推荐)。然后将 ./ghost/content 下的文件 Push 到仓库即可。关于 Git 的使用这里不再介绍,可通过官方文档快速上手。

如果想要实现自动备份则可以在 ./ghost/content 目录下方新建一个脚本文件 auto\_run.sh:

#!/bin/sh

cd /var/www/ghost/content # 切换到目录

sudo git pull # 拉取仓库

sudo git add . # 添加暂存

sudo git commit -m "auto backup" # 提交 commit

sudo git push

特别提醒,你可以添加 .gitignore 文件来排除不需要同步的文件,保证仓库清洁和同步效率。

然后,自动备份就交给 crontab 服务完成。例如,在 crontab 服务中添加 00 16 * * * sh /var/www/ghost/content/auto\_run.sh,则会在每天 16:00 定时执行脚本将更新提交到仓库。

特别留意一下 crontab 服务的运作状态,以防止自动备份失效。sudo service cron status 处于 active (running) 状态即代表正常。

如此以来,Ghost 博客数据自动备份就完成了。使用 Github 备份的好处在于可以追踪数据变化,同时避免数据丢失且方便回滚。但有一点不好的是,由于 Ghost 大多数数据都是图片等,二进制文件同步到 GitHub 会使得仓库越来越大。不过,拿我个人的博客来说,数百篇文章加上图片不过百余兆而已,尚且还好。

图片自动压缩

我们在写文章时,一般都会插入图片,而这些图片就存放在 ./ghost/images 下方。同时,图片是增加仓库体积的罪魁祸首,也增加了网页的加载时间。

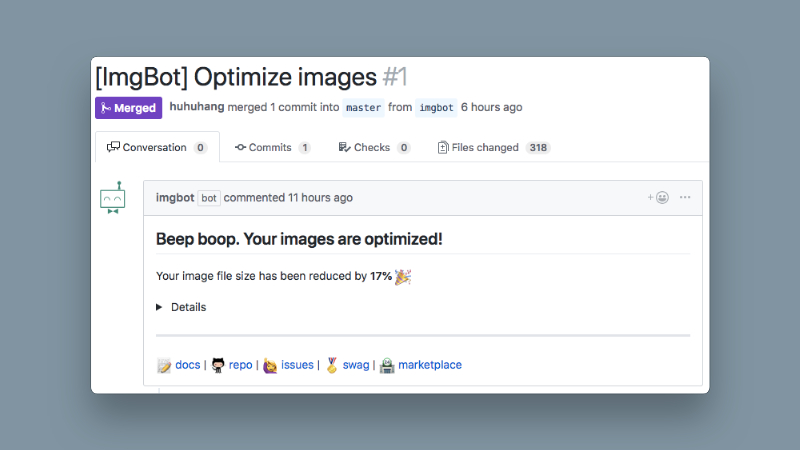

由于使用了 GitHub 同步,压缩图片就可以轻而易举的解决了。GitHub Marketplace 中提供了一个第三方 Bot,名叫 ImgBot。ImgBot 可以遍历仓库,并自动完成图片无损压缩。

你可以通过 此链接 来安装 ImgBot 应用。安装完成之后,ImgBot 会自动提交一个包含压缩后图片的 Pull requests,只需要等待你检查后合并即可。

得益于上面的自动同步机制,这些压缩之后的图片自动在下一个时间节点被同步到云主机。ImgBot 会监测仓库的变化,自动压缩新增加的图片。

如果你不想一些图片被压缩,那么可以在仓库中添加 .imgbotconfig 配置文件排除。

{

"schedule": "daily" // daily|weekly|monthly

"ignoredFiles": [

"*.jpg", // 根据后缀排除

"image1.png", // 根据名称排除

"public/special_images/*", // 根据路径排除

]

}

所以,通过 GitHub 巧妙地解决了数据自动备份和图片压缩问题,Ghost 用起来也越来越得心应手了。